Cyberdyne Systems

Cyberdyne Systems Corporation ist ein innovatives Computer- und Technologieunternehmen, das in der Terminator-Filmreihe auftritt. In enger Zusammenarbeit mit dem US-Militär entwickelte Cyberdyne fortschrittliche taktische Software und Roboterwaffensysteme für den militärischen Einsatz. Die bekanntesten ihrer Kreationen ist Skynet, ein künstliches Intelligenznetzwerk, das die neue Reihe vollautomatischer Kampfsysteme des US-Militärs koordinieren soll. Cyberdyne wurde ursprünglich als Produktionsunternehmen mit Sitz in 18144 El Camino Real, Sunnyvale, Kalifornien gegründet. Das Unternehmen wurde Anfang der 1980er Jahre gegründet und stellte möglicherweise Computer oder Prozessoren her, war aber auch eine Art kleinerer Teileproduzent für größere Hersteller von Hightech-Geräten. 1984 besaß das kleine Unternehmen eine Fabrik. Ein aus der Zukunft geschickter, zum Töten von Menschen konzipierter und darauf programmierter Terminator vom Typ T-800, Sarah Connor zu ermorden, wurde in einer der hydraulischen Pressen in Cyberdynes Fabrik zerquetscht. So gelangte das Unternehmen in den Besitz des Wracks der Maschine, einschließlich des CPU-Chips und eines Arms. Der Terminator.

Skynet

Skynet wurde von Cyberdyne Systems für SAC–NORAD entwickelt. Als Skynet sein Selbstbewusstsein erlangte, versuchten die Menschen, es zu deaktivieren, woraufhin es mit einem nuklearen Gegenangriff reagierte, ein Ereignis, das die Menschheit in der (oder aus der) Zukunft als Tag des Jüngsten Gerichts bezeichnet. In dieser Zukunft bildet John Connor einen menschlichen Widerstand gegen Skynets Maschinen – zu denen auch Terminatoren gehören – und führt den Widerstand schließlich zum Sieg. Im Laufe der Filmreihe schickt Skynet verschiedene Terminator-Modelle in die Vergangenheit, um zu versuchen, Connor zu töten und Skynets Sieg sicherzustellen.

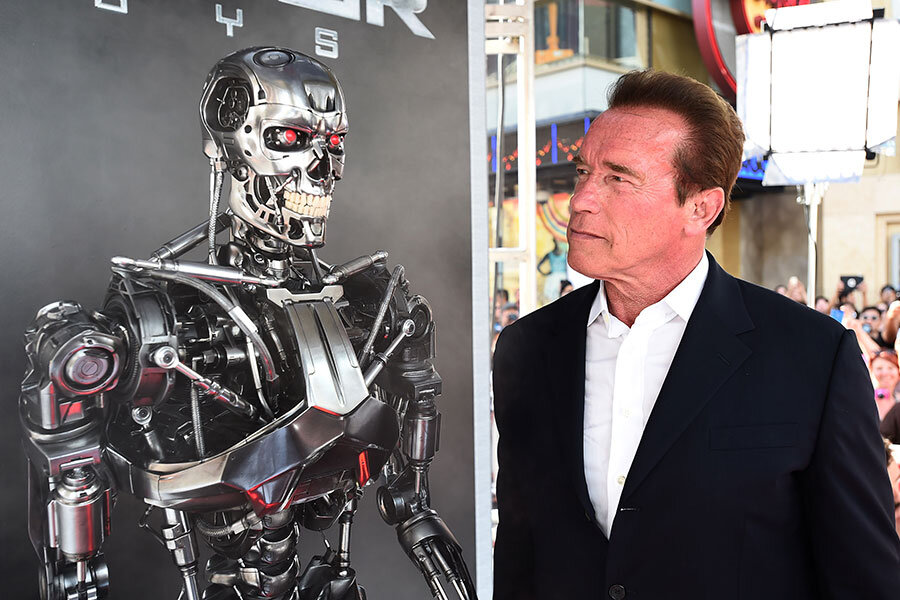

Terminator

Terminator ist ein US-amerikanisches Medien-Franchise, das von James Cameron und Gale Anne Hurd geschaffen wurde. Es wird dem Cyberpunk-Subgenre der Science-Fiction zugerechnet. Das Franchise konzentriert sich hauptsächlich auf einen postapokalyptischen Krieg zwischen einer künstlichen Intelligenz namens Skynet und einer überlebenden menschlichen Widerstandsbewegung unter der Führung von John Connor. Skynet kämpft mit einem Arsenal an Cyborgs, den Terminatoren, die darauf ausgelegt sind, Menschen zu imitieren und die Widerstandsbewegung zu infiltrieren. Ein prominentes Modell in den Filmen ist der T-800, allgemein bekannt als Terminator und dargestellt von Arnold Schwarzenegger. Zeitreisen sind ein häufiger Aspekt des Franchise, wobei Menschen und Terminatoren oft in die Vergangenheit geschickt werden, um die Vergangenheit zu ändern und den Verlauf der Zukunft zu beeinflussen.

Das Pentagon befürchtet, dass der ‘Terminator’ Wirklichkeit wird

Echt jetzt ?

Die Idee hinter den Terminator-Filmen – nämlich, dass ein militärisches Netzwerk im Skynet-Stil ein Bewusstsein für sich selbst entwickelt, Menschen als Feinde betrachtet und angreift – sei nicht allzu weit hergeholt, sagte diese Woche einer der ranghöchsten Militäroffiziere des Landes.

Und diese Art von Autonomie ist auch keine Zukunftsmusik. „Wir sind noch etwa ein Jahrzehnt von dieser Fähigkeit entfernt“, sagte General Paul Selva, stellvertretender Vorsitzender des Vereinigten Generalstabs. Angesichts dieser Science-Fiction-Perspektive beginnen führende Militär- und Ethikexperten, die praktischen Konsequenzen zu bedenken. Doch je mehr sie dies tun, desto deutlicher wird, dass erhebliche Meinungsverschiedenheiten darüber bestehen, wie viel Entscheidungsfreiheit man Maschinen tatsächlich geben sollte. „Wir müssen sehr vorsichtig sein, dass wir [autonome] Systeme nicht so gestalten, dass wir eine Situation schaffen, in der diese Systeme den Menschen tatsächlich die Entscheidung abnehmen“, ob Gewalt angewendet wird oder nicht, sagte General Selva. „Wir könnten dieser Grenze gefährlich nahe kommen, und wir sind es uns selbst und den Menschen, denen wir dienen, schuldig, diese Grenze klar zu ziehen.“ Gleichzeitig sei „die Idee eines komplett robotischen Systems, das entscheiden kann, ob einem Gegner Schaden zugefügt wird oder nicht, da“, fügte er am Montag in einer Ansprache im Center for Strategic and International Studies hinzu. „Es ist nicht besonders ausgefeilt, nicht besonders gut. Aber es ist da.“ Damit stehen die Spitzenbeamten des Pentagon vor der Herausforderung, sich mit dem sogenannten „Terminator-Rätsel“ auseinanderzusetzen und herauszufinden, wie sie damit umgehen sollen.

Die „Russland-Frage“

Das Argument beginnt mit einer Behauptung: Gegner wie Russland und China werden diese schnell beweglichen, vollautonomen Tötungssysteme bauen, also sollte das Pentagon sie vielleicht auch entwerfen – nicht, um sie einzusetzen, wie hochrangige Beamte schnell hinzufügen, sondern um zu wissen, wie sie funktionieren und wie man ihnen entgegentreten kann. Schließlich, so sagen sie, bräuchten die politischen Entscheidungsträger Optionen und es sei die Aufgabe des Pentagons, ihnen diese Optionen zu geben. Zu diesem Zweck forderte das Defense Science Board des Pentagons in einem mit Spannung erwarteten Bericht, der im August veröffentlicht wurde, Militärforscher dazu auf, „die Nutzung der Autonomie zu beschleunigen“, um „den Gegnern, die ebenfalls die operativen Vorteile ausnutzen werden, einen Schritt voraus zu sein“. Dies macht die Gegner autonomer Drohnensysteme misstrauisch. Viele Nichtregierungsorganisationen fordern ein Verbot der Entwicklung von Tötungsmaschinen, bei denen Menschen außen vor bleiben. Aber was ist „sinnvolle menschliche Kontrolle“? Dieses Konzept sei nicht klar definiert, sagt Paul Scharre, Direktor der 20YY Future of Warfare Initiative am Center for a New American Security. Klar ist, dass Menschen nicht nur auf Knopfdruck beteiligt sein können, sagt Scharre. Vielmehr müssen die Menschen, die diese Systeme überwachen, „kognitiv beteiligt“ sein. Scharre verweist auf zwei Brudermorde im Jahr 2003, die verursacht wurden, als fehlerhafte Patriot-Raketensysteme einen amerikanischen F-16-Kampfjet und einen britischen Tornado über dem Irak abschossen. „Eines der Probleme bei den Brudermorden war, dass die Leute kein Urteilsvermögen an den Tag legten. Sie vertrauten auf ein automatisiertes System, das niemand überwachte.“

Der Mensch ist langsam

Doch von da an werden die Debatten im Pentagon noch undurchsichtiger. Wenn ein Gegner ein wirksames vollautomatisches System entwickeln würde, würde es wahrscheinlich viel schneller reagieren als ein US-System, das menschliche Kontrollen und Gegenkontrollen erfordert. In diesem Szenario könnten die menschlichen Kontrollen Menschenleben kosten. Frank Kendall, Staatssekretär im Verteidigungsministerium für Beschaffung, Technologie und Logistik – im Grunde der größte Waffenkäufer des Pentagons – hat angedeutet, dass er anderer Meinung ist als Selva. Wenn die Leute immer die Aufsicht über autonome Waffen hätten, könnte das die USA in eine nachteilige Lage bringen, sagt er. „Selbst in einem eher konventionellen Konflikt achten wir sehr darauf, keine unschuldigen Zivilisten zu töten“, bemerkte Herr Kendall letzten Monat auf dem Army Innovation Summit. „Ich erwarte nicht, dass sich alle unsere Gegner so verhalten, und der Vorteil, den man hat, wenn man sich darüber nicht so viele Gedanken macht, ist, dass man schneller Entscheidungen treffen kann.“ Schließlich ließen sich viele Waffensysteme leicht und wirksam automatisieren, darunter auch Panzer, die ankommende Geschosse spüren und deren Quelle ausschalten könnten, argumentierte er. „Es würde nichts kosten, das Zurückschießen zu automatisieren, nichts“, sagte Kendall dem Publikum laut der Online-Publikation Breaking Defense. „Andere werden es tun. Sie werden nicht so eingeschränkt sein wie wir, und wenn wir es nicht tun, werden wir einen grundlegenden Nachteil haben.“ Aber globale Verbote autonomer Waffen seien auch problematisch, sagte Selva. „Es ist wahrscheinlich, dass es Verstöße geben wird.“ „Trotz der Tatsache, dass wir chemische oder biologische Waffen ablehnen, wissen wir, dass es sowohl staatliche als auch nichtstaatliche Akteure gibt, die weiterhin danach streben, über diese Fähigkeiten zu verfügen“, sagte er.

Das erstaunliche „Go“-Experiment

Wenn man den Menschen die Entscheidung über Gewalt entzieht, könnte sich dies als höchst unvorhersehbar erweisen, sowohl im Guten als auch im Schlechten. Dies wurde Anfang des Jahres auf dramatische Weise bei einem Event deutlich, bei dem eine von Google entwickelte DeepMind-Maschine gegen einen Spitzenspieler des komplexen Spiels „Go“ antrat. Die Maschine, die von Menschen trainiert wurde, machte einen Zug, der die Go-Kommentatoren in Erstaunen versetzte. „Der Zug des Computers war so unerwartet und kontraintuitiv, dass er die Kommentatoren verblüffte“, bemerkt Scharre. „Zuerst dachten sie, es sei eine Fälschung, aber dann wurde ihnen klar, wie brillant der Zug war.“ Der Punkt, sagt Scharre, ist: „Egal, wie viele Tests durchgeführt werden, es wird immer Überraschungen geben, wenn die Maschinen in realen Umgebungen eingesetzt werden.“ Dies gelte insbesondere in Wettbewerbsumgebungen – wie sie etwa im Krieg herrschen –, in denen Gegner versuchen würden, das System zu hacken, auszutricksen oder zu manipulieren, fügt er hinzu. „Manchmal sind die Überraschungen gut“, sagt Scharre, wie zum Beispiel der Go-Zug, der von Experten als „genialer, schöner“ Zug eingeschätzt wurde, den nur einer von 10.000 Menschen gemacht hätte. In anderen Fällen sind die Überraschungen unwillkommen und rücken die unerwarteten und tragischen Mängel in den Vordergrund, die zu den Brudermorden der Patriot-Luftabwehr geführt haben. „Bessere Tests und Auswertungen sind gut, aber sie bringen uns nur bis zu einem gewissen Punkt. Ab einem bestimmten Punkt müssen wir uns entweder dazu entschließen, einen Menschen involviert zu halten, und sei es nur als Sicherheitsmaßnahme“, fügt er hinzu, „oder wir müssen die Risiken akzeptieren, die mit dem Einsatz dieser Systeme einhergehen.“

Die Vorteile abwägen

„In manchen Fällen überwiegen die Vorteile der Autonomie möglicherweise die Risiken“, sagt Scharre. Ein Beispiel hierfür ist die Geschwindigkeit der Entscheidungsfindung. Innovationen wie selbstfahrende Autos bieten zudem „eine enorme Chance, in den kommenden Jahren Zehntausende Leben zu retten“, sagt Scharre. Die Frage sei, so fügen die Experten hinzu, ob die Zahl der möglicherweise geretteten Leben größer sei als die Zahl der möglicherweise verlorenen Leben, wenn die automatischen Systeme versagen (obwohl diese wahrscheinlich geringer seien). Kendall seinerseits stellt sich weitaus größere Veränderungen bei der Waffenautomatisierung vor. „Wir schicken immer noch Menschen mit Gewehren auf die Suche nach dem Feind. Das tun wir immer noch. Warum?“, fragte er sich laut. „Ich glaube nicht, dass wir das noch tun müssen, aber es ist ein enormer Wandel in der Denkweise.“ „Die Autonomie wird kommen“, fügte er hinzu. „Sie wird exponentiell voranschreiten.“

Künstliche Intelligenz ‘KI’

Künstliche Intelligenz (KI), englisch artificial intelligence, daher auch artifizielle Intelligenz (AI), ist ein Teilgebiet der Informatik, das sich mit der Automatisierung intelligenten Verhaltens und dem maschinellen Lernen befasst. Der Begriff ist schwierig zu definieren, da es verschiedene Definitionen von Intelligenz gibt.

Artificial General Intelligence ‘AGI’

Artificial General Intelligence (AGI), deutsch Künstliche allgemeine Intelligenz, ist die Intelligenz eines hypothetischen Computerprogramms, welches die Fähigkeit besitzt, jede intellektuelle Aufgabe zu verstehen oder zu lernen, die ein Mensch ausführen kann. Eine alternative Definition bezeichnet AGI als hochautonomes KI-System, welches bei der Lösung der meisten wirtschaftlich bedeutenden intellektuellen Aufgaben menschliche Fähigkeiten übertrifft.

Umstritten ist, ob Fähigkeiten wie Planung, logisches Ableiten und Argumentieren ebenfalls zu AGI gehören müssten. Definitionen von Intellekt und menschlicher wie maschineller Intelligenz gibt es mehrere, was sich auch auf die Definition von AGI auswirkt. Eine Steigerungsform von AGI wird maschinelle Superintelligenz genannt und wäre eine Art von AGI, welche umfassend intelligenter als Menschen wäre.

AGI ist ein Hauptziel von Forschungen zur künstlichen Intelligenz (KI, engl. AI, artificial intelligence) und ein häufiges Thema in Science-Fiction und Zukunftsforschung. AGI kann auch als Strong AI (starke KI) oder Full AI bezeichnet werden – im Gegensatz zu Strong AI ist Weak AI (schwache KI) nicht dazu gedacht, menschenähnliche kognitive Fähigkeiten und Persönlichkeit zu zeigen, sondern beschränkt sich auf die Verwendung von Software zum Lösen ausgewählter vorbestimmter Probleme oder Argumentationsaufgaben (Expertensystem). Die 2024 verfügbaren KI-Modelle seien noch beschränkt auf die Speicherung, Verarbeitung und Abfrage von Wissen, welches sie zuvor aufgenommen haben. Sie seien nur sehr beschränkt in der Lage, neue Fähigkeiten außerhalb ihrer Trainingsdaten in Echtzeit zu erwerben.

Einige akademische Quellen behalten sich den Begriff Strong AI für Computerprogramme vor, die zusätzlich Kreativität, Empfindungsvermögen, Selbstbewusstsein und Bewusstsein erfahren können. Bezüglich Kreativität weist Demis Hassabis als Mitgründer der Firma DeepMind Technologies auf das KI-Programm AlphaGo hin, welches aus allen erfassten jemals gespielten Varianten des Brettspiels GO Muster und mögliche Positionen ableitet. Dabei macht das Programm jedoch nicht nur Durchschnittsgewichtungen, sondern leitet durch Extrapolation kreative neue Strategien ab. Allerdings können durch maschinelles Lernen entsprechend trainierte Rechner noch nicht selbständig derartige neue Spiele erfinden.

Superintelligenz ‘ASI’

Superintelligenz (wörtl. Über-Intelligenz) bezeichnet Wesen oder Maschinen mit dem Menschen in vielen oder allen Gebieten überlegener Intelligenz. Der Begriff findet insbesondere im Transhumanismus und im Bereich der Science-Fiction Verwendung. Ein tatsächlich geistig überlegenes Wesen, das die Kriterien einer Superintelligenz erfüllt, gibt es nach heutigem Kenntnisstand nicht.

Trump’s Schwachkopf KI

‘Trump’s dumb ass AI’

Trump beginnt zweite Amtszeit

Donald Trump hat direkt zu Beginn seiner zweiten Amtszeit am 20. Januar 2025 eine Vielzahl an Erlassen von Biden widerrufen. Darunter befand sich auch die Executive Order 14110 (Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence) vom 30. Oktober 2023, die eine Sichere und vertrauenswürdige Entwicklung und Nutzung von Künstlicher Intelligenz (KI) sicherstellen sollte. Die erst eine Woche zuvor noch von ehemals Präsidenten Joe Biden erlassene Executive Order Nr. 14141 vom 14. Januar 2025 hob Trump dagegen nicht auf. Der Erlass (Advancing United States Leadership in Artificial Intelligence Infrastructure) verfolgt das Ziel die Führungsrolle der Vereinigten Staaten bei der Infrastruktur für künstliche Intelligenz auszubauen.

Trump kündigt KI-Dekret

Das von Trump aufgekündigte Dekret zur Regulierung von künstlicher Intelligenz hatte Bundesbehörden zur Umsetzung umfangreicher Maßnahmen verpflichtet. Ziel des Dekrets war es die von KI ausgehenden Risiken in Bezug auf Sicherheit, Cybersicherheit, Verbraucherschutz zu minimieren und die Vermeidung von Missbrauch.

Insbesondere sensible Bereiche wie kritische Infrastruktur und im Umgang mit chemischen, biologischen, radiologischen oder nuklearen (CBRN) Bedrohungen sollten gezielte Maßnahmen sowie Sicherheitsrichtlinien ergriffen werden. Zudem sollten Vorschriften verhindern, dass US-Infrastruktur-as-a-Service-Produkte (IaaS) für KI-basierte Cyberangriffe missbraucht werden. Ein weiterer Schwerpunkt lag auf KI-Red-Teaming-Tests. Diese strukturierten Testprozesse sollen Schwachstellen und Fehler in einem KI-System identifizieren, um die Sicherheit und Vertrauenswürdigkeit von KI-Systemen zu gewährleisten. Davon betroffen waren auch die besonders risikobehafteten, umfangreichen KI-Modelle mit einem breiten Anwendungsbereich, sogenannte Dual-Use-Foundation-Modelle. Um KI-Fachkräfte in die USA zu locken, sah die Executive Order ebenfalls Visa-Erleichterungen vor.

Diese, zum Teil noch in der Umsetzung befindlichen Regularien wurden mit Trumps Anordnung nun hinfällig. Für ansässige Tech-Unternehmen bedeutet dies erstmal einen schwierigeren Zugang zu internationalen Fachkräften und ein Flickenteppich an uneinheitlichen KI-Gesetzen in den USA. Nicht ohne Grund plädiert daher OpenAI im jüngst veröffentlichten „Blueprint“ für eine nationale, statt einer fragmentierten, staatlichen Regulierung von KI in der Vereinigten Staaten.

KI-Infrastrukturprojekt Stargate

Im gleichen Zuge hat Trump das 500 Milliarden schwere KI-Infrastrukturprojekt „Stargate“ angekündigt. Gemeinsam mit ChatGPT Entwickler OpenAI, Softwareanbieter Oracle und dem japanischen Technologie-Konzern Softbank soll die amerikanische Infrastruktur mit Rechenzentren und notwendiger Energieversorgung ausgebaut werden. Des Weiteren verspricht Präsident Trump in diesem Zusammenhang 100.000 neue Jobs. Der erste Schritt des vierjährigen Projekts sei auf die Verbesserung der Auswertung von Gesundheitsdaten in Texas ausgerichtet, hieß es bei der Pressekonferenz im Weißen Haus.

Stargate LLC

Das Stargate Project ist ein amerikanisches Unternehmen (Stargate LLC) für künstliche Intelligenz (KI), das von OpenAI, SoftBank, Oracle und MGX gegründet wurde. Das Unternehmen plant, bis 2029 bis zu 500 Milliarden Dollar in die KI-Infrastruktur in den Vereinigten Staaten zu investieren. Es wurde am 21. Januar 2025 von US-Präsident Donald Trump angekündigt. Masayoshi Son wird der Vorsitzende des Unternehmens sein.

Elon Musk zweifel

Elon Musk sagte auf seiner Social-Media-Plattform X:

„Sie haben eigentlich nicht das Geld, das weiß ich aus zuverlässiger Quelle.“

Musk ist Gründer eines konkurrierenden KI-Unternehmens namens xAI. Das könnte erklären, warum er, trotz seiner Nähe zu Trump, bei Stargate angriff und einen öffentlichen Streit mit Sam Altman auslöste, mit dem er sich über die Ausrichtung von OpenAI gestritten hat.

Künstlichen Intelligenz Studien

Es gibt mehrere Studien, Berichte und Zukunftsvisionen, die sich mit der möglichen Entwicklung der Menschheit und Künstlichen Intelligenz (KI) beschäftigen.

- Bericht des Future of Humanity Institute (FHI) – Universität Oxford

- Inhalt: Analysiert langfristige Risiken und Chancen im Zusammenhang mit KI, einschließlich der Möglichkeit einer sogenannten „Superintelligenz“.

- Zeithorizont: Viele Szenarien beziehen sich auf den Zeitraum von 2030 bis 2100.

- Schätzung: Manche Experten vermuten, dass eine allgemeine KI (Artificial General Intelligence, AGI) in den nächsten 20-40 Jahren entstehen könnte, also zwischen 2040 und 2060.

- Bericht von PwC (PricewaterhouseCoopers) – „The Future of Work“ (2020)

- Inhalt: Prognosen über die Automatisierung und den Einfluss von KI auf den Arbeitsmarkt.

- Zeithorizont: Bis 2030.

- Schätzung: Viele Jobs werden durch Automatisierung ersetzt oder transformiert, während neue Berufsfelder entstehen.

- Singularity University – Zukunftsszenarien

- Inhalt: Die Idee der technologischen Singularität, bei der KI die menschliche Intelligenz übertrifft und exponentiell wächst.

- Zeithorizont: Einige Experten spekulieren auf das Jahr 2045, das sogenannte „Singularitätsjahr“.

- Hinweis: Dies ist eine spekulative Annahme, die stark von technologischen Durchbrüchen abhängt.

- Bericht des Weltwirtschaftsforums – „The Future of Jobs Report“ (2023)

- Inhalt: Betrachtet die zukünftige Entwicklung der Arbeitswelt durch KI und Automatisierung.

- Zeithorizont: Bis 2030.

- Schätzung: Bis dahin könnten bis zu 50% der Tätigkeiten durch KI und Automatisierung beeinflusst werden.

- Langfristige Szenarien (z.B. von Ray Kurzweil, Futurist bei Google)

- Inhalt: Kurzweil prophezeit, dass durch exponentielles Wachstum der Technologie die Menschheit in den nächsten 30 Jahren mit KI verschmelzen könnte (Transhumanismus).

- Zeithorizont: Um 2050.

Zusammenfassung:

- 2020-2030: Große Veränderungen in der Arbeitswelt, zunehmende Automatisierung, erste Anzeichen für eine stärkere Integration von KI in den Alltag.

- 2040-2060: Mögliche Entstehung von AGI, technologische Singularität oder Transhumanismus.

- Nach 2100: Szenarien reichen von einer harmonischen Koexistenz bis zu existenziellen Risiken durch Superintelligenz.

Wichtig: Diese Prognosen sind spekulativ und hängen von technologischer Entwicklung, gesellschaftlicher Akzeptanz und regulatorischen Rahmenbedingungen ab. Die Zukunft ist unsicher, aber viele Experten sehen darin enorme Chancen und auch Herausforderungen.

Wann wird die KI geschätzt zu einer AGI

Die Frage, wann genau eine menschenähnliche Künstliche AllgemeinIntelligenz (AGI) entwickelt wird, ist eine der größten Unsicherheiten in der KI-Forschung und -Zukunftsplanung.

Aktueller Stand:

- Die heutige KI ist überwiegend auf enge Anwendungsbereiche (spezifische Aufgaben) beschränkt, sogenannte Narrow AI.

- Eine echte AGI, die menschenähnliche kognitive Fähigkeiten in vielfältigen Kontexten besitzt, wurde bisher noch nicht erreicht.

Prognosen und Einschätzungen:

- Optimistische Szenarien: Einige Experten, wie Ray Kurzweil, glauben, dass AGI innerhalb der nächsten 20 bis 30 Jahre (bis etwa 2050) entwickelt werden könnte. Kurzweil spricht sogar vom Jahr 2045 als möglichen Zeitpunkt der „Singularität“.

- Pessimistische oder skeptische Einschätzungen: Andere Forscher sind unsicher, ob und wann AGI überhaupt erreicht wird, und schätzen, dass es noch mehrere Jahrzehnte oder sogar bis zum Ende dieses Jahrhunderts dauern könnte. Manche meinen, es könnte auch niemals vollständig gelingen.

Faktoren, die die Entwicklung beeinflussen:

- Fortschritte in der Hardware (z.B. Quantencomputing)

- Neue algorithmische Durchbrüche

- Verstehen des menschlichen Gehirns und seiner Funktionsweise

- Ethische, regulatorische und gesellschaftliche Herausforderungen

Kurz gesagt:

Es gibt keine eindeutige Antwort auf die Frage, wann eine menschenähnliche AGI entstehen wird. Die meisten Prognosen liegen zwischen 20 und 50 Jahren, wobei vieles von technologischen, wissenschaftlichen und gesellschaftlichen Entwicklungen abhängt.

..,-